Principais conclusões

- Os chips são cruciais para o desempenho da IA em dispositivos e servidores em nuvem, permitindo velocidades de computação mais rápidas e suportando fluxos de trabalho mais exigentes.

- Grandes empresas de tecnologia como Nvidia, Intel, AMD, Google, Meta e Microsoft estão competindo na fabricação de chips de IA.

- O sucesso no software de IA depende do desenvolvimento de chips avançados de IA, e a liderança da Nvidia sobre todos os outros mostra que há incentivo financeiro para a fabricação de chips também.

É fácil ver os aplicativos de inteligência artificial para o consumidor em 2024, como ferramentas de software como o ChatGPT da OpenAI ou produtos de hardware como o AI Pin da Humane. No entanto, estes são apenas a ponta do iceberg quando se trata de desenvolvimento de IA. Esteja você olhando para software ou hardware baseado em IA, seu sucesso pode ser atribuído à fabricação de chips. Alguns desses produtos e serviços aproveitam o processamento de IA no dispositivo e outros transferem os requisitos de processamento para servidores em nuvem. De qualquer forma, o silício personalizado é a espinha dorsal da IA, e é por isso que todas as grandes empresas de tecnologia estão envolvidas em uma corrida nos bastidores para criar os melhores processadores de IA para ótimos PCs de IA e servidores em nuvem.

O que é um AI PC e vale a pena exagerar?

Explore o mundo dos PCs com IA e descubra se todo o entusiasmo é justificado.

Por que os chips são cruciais para o desempenho da IA

Eles tornam possíveis aplicações de IA, sejam elas no dispositivo ou na nuvem

Smartphones e laptops estão começando a incluir unidades de processamento neural (NPUs) projetadas para gerenciar especificamente tarefas relacionadas à IA. Comparado a uma CPU ou GPU tradicional, um NPU pode lidar com a execução de funções e analisar informações em paralelo muito melhor. Portanto, embora uma GPU possa processar uma consulta que exija aprendizado profundo ou de máquina, uma NPU acelera as coisas. Usar uma NPU em comparação com outros tipos de processador não só permitirá uma computação de IA mais rápida, mas também permitirá fluxos de trabalho mais exigentes. É por isso que a Apple fornece sistemas em um chip com motores neurais há anos, tanto em smartphones quanto em dispositivos móveis. Ultimamente, as NPUs também se tornaram uma grande parte do hardware do PC. Os dois maiores nomes do processamento para consumidores – Intel e AMD – incorporaram NPUs em seus chips.

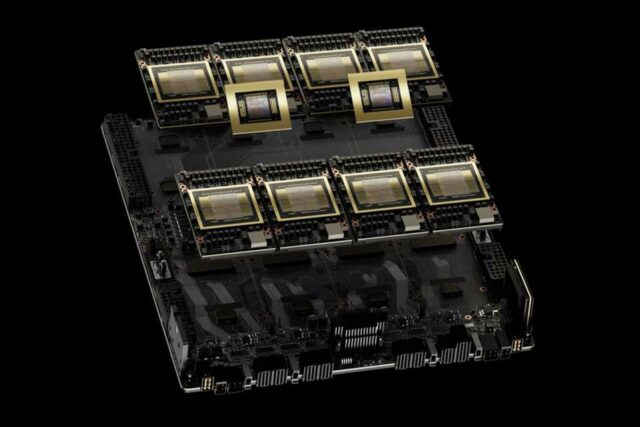

No entanto, os NPUs apenas ajudam na execução de recursos de IA no dispositivo. A maioria das ferramentas e recursos de software baseados em IA hoje são executados fora do dispositivo, transferindo os requisitos de processamento para um servidor em nuvem em outro lugar. Por exemplo, se você fizer uma pergunta a um chatbot de IA como ChatGPT, Copilot ou Gemini, ele enviará essa solicitação a um servidor e a processará. Mas é importante lembrar que os processadores de IA também são necessários para alimentar os servidores nos centros de processamento de dados. Na verdade, os processadores avançados de IA usados para preencher racks de servidores em data centers são muito mais procurados do que chips de consumo. A Nvidia é atualmente líder do setor em processadores de IA, e suas GPUs H100 especializadas para aprendizado profundo e tarefas de IA são difíceis de encontrar, custando mais de US$ 40.000 cada no mercado de segunda mão.

Nvidia HGX vs DGX: Quais são as diferenças?

Como as soluções empresariais de GPU da Nvidia para computação de IA de alto desempenho diferem

Como resultado, todos os participantes da indústria de tecnologia estão observando o que a Nvidia está fazendo com suas GPUs avançadas, incluindo a já mencionada H100 e a recém-anunciada H200. Esses chips e os cartões que os contêm são cruciais para executar os grandes modelos de linguagem (LLMs) que suportam muitos recursos generativos de IA. Os óbvios são os chatbots, mas também existem geradores de imagens, geradores de vídeo e muito mais. As empresas que criam esses recursos de software – como Google, Microsoft, OpenAI e outras – precisam de chips avançados de IA para potencializar suas ofertas. Assim, em vez de apenas correrem para construir as melhores ferramentas de software de IA, eles também estão competindo para projetar e adquirir os chips que lhes darão vida.

Todo mundo quer um pedaço da criação de chips de IA

Nvidia, Intel, AMD, Google, Meta e Microsoft estão todos perseguindo isso

É por isso que, se você escolher aleatoriamente o nome de uma grande empresa de tecnologia, ela provavelmente estará envolvida na fabricação, design ou fabricação de chips de IA de uma forma ou de outra. O Google anunciou na semana passada um novo tipo de processador chamado Google Axion, que é um chip personalizado baseado em Arm projetado para data centers que oferecem suporte ao Google Cloud. A Microsoft tem dois processadores de IA chegando este ano, Azure Maia e Azure Cobalt, o que poderia ser uma forma de evitar a dependência de componentes da Nvidia. A Meta invadiu o espaço da fabricação de chips com o Meta Training and Inference Accelerator (MTIA) no ano passado e também apresentou uma prévia de uma oferta de próxima geração na semana passada. Amazon Web Services tem um novo processador Trainium2 personalizado para tarefas baseadas em IA, ao mesmo tempo que usa chips Nvidia para seus data centers. O CEO da OpenAI, Sam Altman, também está procurando processadores de IA personalizados.

No momento, todos precisam da GPU H100 da Nvidia para processamento de IA para fornecer serviços em nuvem. Amazon Web Services, Microsoft Azure e Google Cloud são três dos maiores provedores de processamento em nuvem da atualidade. Todos eles dependem da Nvidia para fornecer IA, máquina e computação de aprendizado profundo para seus clientes. A Meta planeja possuir 340.000 GPUs Nvidia H100 até o final de 2024, de acordo com o CEO Mark Zuckerburg, tornando a empresa um concorrente sutil também. No entanto, embora eles dependam da Nvidia por enquanto – e tenham fortemente enfatizou seu relacionamento contínuo com a Nvidia para não queimar nenhuma ponte – esse pode não ser o caso para sempre. Amazon, Microsoft, Google e Meta estão construindo suas próprias alternativas, e a empresa que rivaliza com sucesso com a Nvidia pode ser a vencedora da corrida da IA.

Há muito dinheiro na fabricação de chips de IA

A Nvidia está vencendo a corrida até agora e os preços das ações estão subindo

Portanto, é fácil perceber que as empresas estão se enfrentando para desenvolver melhores recursos de software e LLMs. No entanto, é menos aparente superficialmente que Microsoft, Google, Amazon e Meta precisam vencer uns aos outros em hardware para vencer também em software. Esses dois aspectos da IA estão interligados, pelo menos na situação atual do mercado. A Nvidia é a rainha da IA, e o sucesso de todas as outras empresas depende do acesso às GPUs da Nvidia. Há incentivo financeiro aqui também. No momento em que este artigo foi escrito, os preços das ações da Nvidia aumentaram 218,50% no ano passado e ela se tornou uma empresa de um trilhão de dólares devido ao seu domínio na fabricação de chips de IA. Se há algo que aprendemos ao longo do último boom da IA, é que as empresas de tecnologia provavelmente sobreviverão umas às outras se conseguirem fabricar com sucesso o seu próprio silício.

Nvidia está conquistando a coroa no cenário de hardware de IA

A batalha de hardware de IA está esquentando e a Nvidia está liderando o grupo agora